Sequoia 领投估值 5.5 亿美金,这个华人 AI 称 AI 的未来是复合系统

Fireworks AI 今天宣布,完成了由 Sequoia 领投的 5200 万美金的 B 轮融资,估值达到了 5.52 亿美金。跟投方包括了 英伟达、AMD 以及 MongoDB,其总融资额达到了 7700 万美金。

我在 4 月份的时候曾介绍过 Fireworks,本质上它才是 Benchmarks 投的第一个华人 AI 项目,而并非 HeyGen,它在 2022 年就拿了 Benchmark 领投的 2500 万美金,由合伙人 Eric Vishria 主导,当时 Fireworks 刚成立不久。

其它参与的投资人则包括了此次领投方 Sequoia、Databricks Ventures、Snowflake 前 CEO Frank Slootman、Meta 前 COO Sheryl Sandberg、Airtable CEO Howie Liu、Scale AI CEO Alexandr Wang,以及来自 LinkedIn、Confluent、Meta 和 OnePassword 的高管。

Fireworks 做的事情我觉得非常重要,本质上就是帮助开发者或者企业更高效的接入适合自己 AI 的能力,这里的高效不仅包括了便利性、质量、成本,也包括了安全等,就是怎么样在最快的时间和最低的成本下找到符合自己特定应用场景需要的 AI 模型能力。

因此针对不同的应用场景,在成本最优的情况下,你可能需要接入不同的 AI 模型,但对于大部分企业来说,完全依靠自己接入并微调的成本和能力都比较高,而 Fireworks 就充当了这个中间方,它将所有这些模型的能力都做了微调和整合,以 API 的方式直接提供给开发者,这样你只需要做好自己的选择就好了。

因此它是一个面向开发者的产品,属于 GenAI Platform as a service,他们与世界领先的 AI 研究人员合作提供各种优化过的模型,为开发者构建了一个 Production AI 平台,只需要利用其提供的 API 就使得使用强大的 AI 模型变得非常简单。

主导此次投资的 Sequoia 合伙人 Sonya Huang 在官方博客里说,企业在引入 AI 能力的过程中,会遇到一系列的问题,包括:

- 延迟:客户希望应用接近实时,毫秒级的延迟可能会影响他们的体验和转化率;

- 成本:在生产量和规模化方面,闭源模型的费用会迅速增加;

- 质量 :对于某些测试,较大的模型可能并没有具有特定应用场景的较小、经过微调的模型表现好;

- 模型和数据所有权:许多企业对与外部提供商分享他们的核心技术感到谨慎,并更倾向于在自己的虚拟私有云中进行推理;

- 外部依赖性:公司希望从可靠的云服务提供商那里获得多种模型,这样其关键应用就不会被这个单一的故障源锁死。

因此,团队越来越倾向于采用复合人工智能(Compound AI)系统,这些系统结合了多个模型调用、检索器或外部工具,相比依赖单一模型,能够提供更好的性能、可靠性和控制力。

企业在进入生产环境时正在平衡一系列需求:他们渴望闭源模型提供商的便利性;开源模型提供的延迟、成本、质量和安全性;以及复合系统的多功能性。

同时,Sequoia 认为在过去的 6-9 个月,一个新的拐点已经到来,那就是越来越多的开源替代方案已经变得可行。

这是一个巨大的机遇,Sequoia 预计在未来几年内 AI 将从以训练为主转向以生产为主。而通过满足企业的务实需求并拓展曲线的边界,Fireworks 将有机会成为人工智能时代的重要基础设施提供商。

事实上,Fireworks 自己并不从头开始训练任何基础模型,而是通过帮助优化其他模型来满足企业的特定需求,这样开发人员可以将其 API 集成到应用中,使用他们选择的模型(可以是现成的、开源的模型,也可以是由公司优化的模型,或者是客户自行优化的模型),快速添加生成式 AI 功能。

而且它允许公司尝试多个模型,这种方法快速、高效,并产生高质量的结果。更重要的是,与 GPT4 的超过 1 万亿个参数相比,Fireworks 将模型大小限制在 70 亿至 130 亿个参数之间,从而大大降低了成本。

与同类型模型相比,其价格往往会低 1-2 个数量级。虽然这限制了大型语言模型所能理解的单词范围,但却能让开发人员专注于更小、更集中的数据集,以应对更有限的业务应用场景。

而 Fireworks 不只是简单地提供一套工具(比方说推理和微调),而是构建一个完整的解决方案,根据客户的特定要求提供模型和功能的最佳组合。

CEO Lin Qiao 在 Fireworks 官方博客里说,自成立以来,Fireworks AI 已为开发人员提供最快、最具成本效益的流行模型推理。

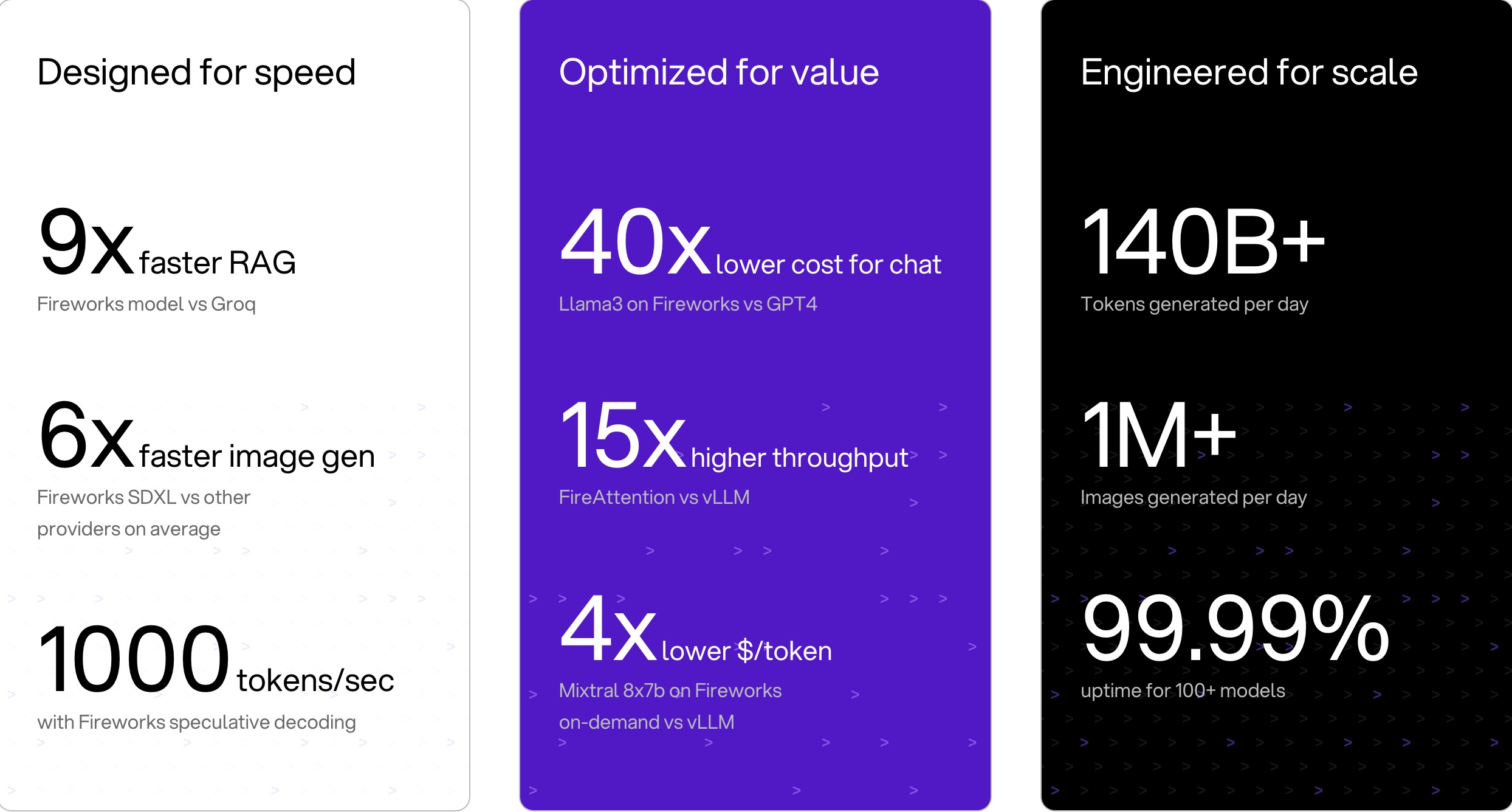

今天,Fireworks 以文本、图像、音频、嵌入和多模态格式提供 100 多种最先进的模型,并针对延迟、吞吐量和每个令牌的成本进行了优化。

与 vLLM 相比,他们将推理时间缩短了 12 倍,与 GPT4 相比,推理时间缩短了 40 倍。每天在其平台上处理 的 Token 超过了 1400 亿,API 的正常运行时间达到了99.99%。

Lin Qiao 说,与通用、非私有且难以定制的专有大型模型不同,Fireworks AI 提供较小的生产级模型,可以私密且安全地部署。像最近他们推出的 Firefunction-v2 ,一个与 GPT-4o 相当的函数调用模型,速度是 GPT-4o 的 2.5 倍,成本却只有 GPT-4o 的 10%。

Lin Qiao 认为 AI 的未来是复合系统,尽管各种排行榜强调更大的模型,但实际世界中的 AI 结果,特别是在生产中,越来越多地来自具有多个组件的复合系统。

复合 AI 系统使用多个相互作用的部分来处理任务